Chancen und Schwierigkeiten von Quantencomputern

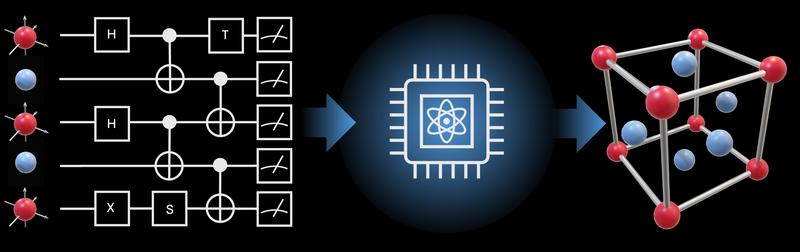

Quantencomputer bieten die Möglichkeit, Festkörperstrukturen zu simulieren, die selbst die besten Supercomputer nicht berechnen können. Gleichzeitig sind die modernen Systeme jedoch noch sehr störanfällig und können Ergebnisse verfälschen. JProf. Benedikt Fauseweh von der Fakultät Physik der TU Dortmund hat die wichtigsten bisherigen Anwendungsfälle analysiert und dabei Chancen und Schwierigkeiten in der digitalen Quantensimulation herausgearbeitet. Sein Perspektivartikel wurde kürzlich in der renommierten Fachzeitschrift Nature Communications veröffentlicht.

Die Quantenmechanik erklärt das Verhalten von Teilchen auf atomarer Ebene und ist damit grundlegend für das Verständnis unserer Welt, insbesondere in der Festkörperphysik. Sie beschreibt die Wechselwirkungen von Elektronen und Atomkernen in Kristallen und kann daher Materialeigenschaften wie Leitfähigkeit, Magnetismus und Supraleitung erklären. Die Komplexität der Wechselwirkungen zwischen vielen Teilchen stellt jedoch eine besondere Herausforderung dar, denn sie übersteigt die Möglichkeiten aller heute verfügbaren Supercomputer. Selbst mit einer erhöhten Rechenleistung wären herkömmliche Computer nicht in der Lage, genaue Lösungen für viele Quantenphänomene zu liefern.

Dieses fundamentale Problem könnte durch die digitale Quantensimulation gelöst werden. Das Konzept wurde erstmals 1982 von dem Physiker Richard Feynman vorgeschlagen und nutzt die Prinzipien der Quantenmechanik, um das Verhalten von Quantensystemen zu simulieren. Mit der Entwicklung moderner Quantencomputer rückt die Umsetzung Feynmans visionärer Idee näher. Eine wesentliche Hürde bleibt jedoch: die inhärente Instabilität aktueller Quantencomputer. Diese fortschrittlichen Maschinen sind bei komplexen Berechnungen anfällig für Fehler, die die Simulationsergebnisse verfälschen können.

In einem Perspektivartikel der Fachzeitschrift Nature Communications hat Benedikt Fauseweh, Juniorprofessor an der Fakultät Physik und affiliierter Wissenschaftler am Deutschen Zentrum für Luft- und Raumfahrt (DLR), die bisherigen Ergebnisse von Forschungsgruppen weltweit analysiert. Seine Auswertung zeigt, dass die meisten Simulationen nur mit sehr wenigen Quantenbits durchgeführt wurden. „Je mehr Quantenbits verwendet werden, desto mehr Teilchen können simuliert werden – eine unabdingbare Voraussetzung, um auch komplexe Quantenphänomene zu beschreiben“, erklärt JProf. Benedikt Fauseweh. „Werden jedoch zu viele Quantenbits verwendet, sind die Ergebnisse aufgrund der Fehler im Quantencomputer nicht mehr brauchbar.“

Qualität vor Quantität

Angesichts dieses Dilemmas plädiert Fauseweh derzeit für einen Mittelweg: „Wir müssen jene Anwendungen und Probleme identifizieren, die auch bei Fehlern im Quantencomputer noch ein richtiges Ergebnis liefern. Das bedeutet: Qualität vor Quantität.“ Solange Quantencomputer noch so fehleranfällig sind, können mit ihnen keine quantitativen Probleme gelöst werden, die hinter dem Komma mehr als fünf Stellen Genauigkeit erfordern. Es können allerdings grundlegende physikalische Fragen geklärt werden, zum Beispiel welches Material sich eignet, um bessere Quantenbits zu bauen.

In Zukunft könnte die digitale Quantensimulation dadurch sowohl eine wichtige Rolle in der Grundlagenforschung einnehmen als auch die Entwicklung von Quantentechnologien selbst verbessern. „Gordon Moore hatte schon in den 1960er-Jahren vorhergesagt, dass sich die Rechenpower von Computern ungefähr alle zwei Jahre verdoppeln wird. Dieser exponentielle Anstieg hat unser heutiges, digitales Zeitalter ermöglicht“, sagt JProf. Benedikt Fauseweh. „Mithilfe von digitaler Quantensimulation könnte eine Quantenversion des Mooreschen Gesetzes in Gang gebracht werden, die eine kontinuierliche Verbesserung von Quantencomputern ermöglicht und so ein Quantenzeitalter einleitet.“

Wissenschaftlicher Ansprechpartner:

https://physik.tu-dortmund.de/forschung/forschungsschwerpunkt-kondensierte-materie/jun-prof-dr-benedikt-fauseweh/

Originalpublikation:

https://doi.org/10.1038/s41467-024-46402-9

Ähnliche Pressemitteilungen im idw